Cybersécurité, cloud et IA : le top des actualités IT de la semaine

Cybersécurité, cloud et IA : le top des actualités IT de la semaine

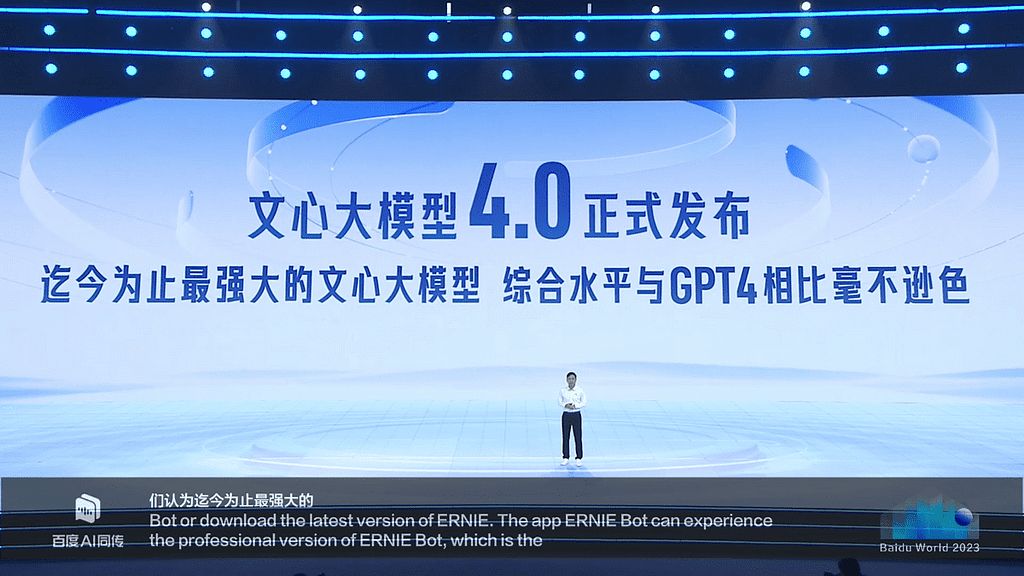

ERNIE 4.0 : le rival de GPT- 4

Lors de la conférence annuelle de Baidu, Robin Li, le PDG de l’entreprise a présenté la dernière version de son modèle d’IA, Ernie 4 .0. Il affirme d’ailleurs que son outil “n’est aucun point inférieur à GPT-4” d’Open AI. Il a annoncé que le modèle a subi une refonte totale et que les performances en termes de compréhension, de génération, de raisonnement et de mémoire ont considérablement été améliorées.

Selon lui, l’outil pourrait comprendre des questions et instructions complexes grâce à sa capacité d’appliquer le raisonnement et la logique.

Li a effectué une démonstration en live de l’outil de Baidu (voir vidéo ci-dessous), durant laquelle les capacités de Ernie 4.0 en termes de créations de supports publicitaires et de rédaction ont pu être démontrées. L’outil a pu produire une affiche et une vidéo marketing ainsi qu’un roman portant sur les arts martiaux anciens.

Il est prévu que Ernie 4 soit intégrée aux nombreux produits et services de Baidu notamment : le moteur de recherche, ses services de cloud computing et ses offres de business intelligence.

A l’heure actuelle, il est difficile de dire si Ernie possède ou pas les mêmes capacités que GPT-4. Quoi qu’il en soit, cette présentation témoigne de sa volonté de rester à l’avant-garde dans ce secteur.

Vers la fin du protocole NTLM au profit de Kerberos

L’authentification NTLM (New Technology LAN Manager) est un protocole d’authentification utilisé dans les systèmes d’exploitation Windows. Microsoft a développé cette suite de protocoles de sécurité pour vérifier l’identité des utilisateurs et protéger leurs données.

Le mécanisme d’authentification des utilisateurs de NTLM est fondé sur des défis/réponses impliquant trois messages : négociation, challenge et réponse.

Le protocole NTLM présente cependant de nombreuses failles qui le rendent plus vulnérables aux cyberattaques notamment les failles de sécurité liées au hachage et au salage des mots de passe ce qui augmente les cyberattaques.

C’est pourquoi NTLM a été remplacé sur les versions de Windows supérieures à Windows 2000 par Kerberos. Alors quelles fonctionnalités seront présentes dans Kerberos ?

Quelques fonctionnalités supplémentaires attendues dans Kerberos

Deux principales fonctionnalités sont attendues dans Kerberos notamment :

- IAKerb (Initial and Pass Through Authentication Using Kerberos) : Cette fonctionnalité permettra aux utilisateurs de s’authentifier avec Kerberos dans un plus grand nombre de topologies de réseau.

- KDC local (Local Key Distribution Center): Il s’agit d’un centre de distribution de clés local pour Kerberos. Il élargit la prise en charge du protocole aux comptes locaux.

En outre, Microsoft envisage d’étendre les contrôles de gestion NTLM afin d’offrir aux administrateurs une plus grande flexibilité dans la surveillance et la restriction de son utilisation.

Bien que les utilisateurs continuent d’utiliser NTLM qui est au sujet aux cyberattaques, Microsoft recommande aux développeurs de ne plus utiliser NTLM dans leurs applications. Par ailleurs, il invite les administrateurs Windows à désactiver NTLM ou à configurer leurs serveurs afin de bloquer les attaques.

« Tous ces changements seront activés par défaut et ne nécessiteront pas de configuration pour la plupart des scénarios. NTLM restera disponible comme solution de repli pour maintenir la compatibilité existante », a déclaré Matthew Palko, directeur produit entreprise et sécurité chez Microsoft.

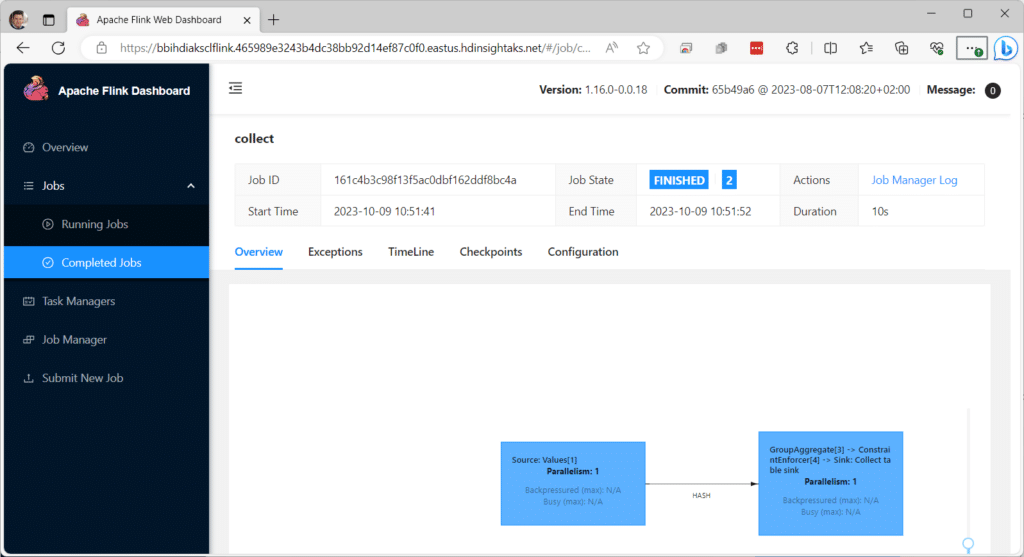

Microsoft effectue une refonte totale de son stack data sur le cloud

Microsoft modernise HDInsight, son stack data sur le cloud, en vue de renforcer ses capacités.

HDInsight est un service d’analyse de Big Data proposé par Microsoft Azure. Il s’agit plus précisément d’une plateforme permettant le traitement et l’analyse d’importants volumes de données grâce à divers frameworks open source.

La semaine dernière, Microsoft a présenté la démo de la nouvelle version de son stack data sur le cloud. HDInsight est basé sur 03 infrastructures open source dont :

– Apache Spark

– Trino

– Apache Flink

Ce qui lui permet d’assurer la prise en charge de trois types de clusters.

Par ailleurs, les machines virtuelles ont été remplacées par des technologies de conteneurs pour assurer le fonctionnement de HDInsight. Ce qui fluidifiera le processus de provisionnement des clusters individuels.

IA en Afrique : La fondation Gates donne 30 millions $

Le 10 octobre,lors de la réunion des “Grands Challenges” qui s’est tenue à Dakar, Bill Gates annonçait le décaissement de 30 millions de dollars de la Fondation Bill et Melinda Gates pour le développement d’une plateforme d’intelligence artificielle en Afrique.

La plateforme devrait servir de soutien technique et opérationnel aux scientifiques afin qu’ils puissent transformer des idées innovantes en matière de santé et de développement en solutions évolutives concrètes.

Le but étant de faciliter l’accès à l’intelligence artificielle à tous et de s’assurer que ces outils soient développés de manière sûre, éthique et équitable.

« Le monde doit s’assurer que tout le monde – et pas seulement les personnes qui sont aisées – bénéficient de l’intelligence artificielle. Le gouvernement et la philanthropie devront jouer un rôle majeur pour s’assurer qu’elle réduit l’inégalité et n’y contribue pas. C’est la priorité de mon propre travail lié à l’IA », avait déclaré Bill Gates lors d’une interview en mars dernier.

Cette initiative s’inscrit dans le cadre de ses objectifs de soutenir l’innovation technologique, particulièrement dans le domaine de l’intelligence artificielle, dans les pays à faible revenu dans le monde. Un financement de 5 millions de dollars pour les projets liés à l’intelligence artificielle avait d’ailleurs été annoncé en août dernier.

L’Oréal choisit la plateforme Lakehouse de Databricks pour renforcer l’expérience client

L’Oréal choisit Databricks afin de garantir l’interopérabilité de sa plateforme mondiale de données Beauty Tech et poursuivre sa stratégie multi cloud.

Depuis plusieurs années, l’Oréal utilise les nouvelles technologies pour offrir des services très personnalisés aux consommateurs, ou pour stimuler ses ventes comme ça a été le cas pendant la pandémie.

La plateforme Lakehouse est une architecture hybride de gestion des données combinant les data lakes et les data warehouses. Elle vise à fournir une solution de stockage, de traitement et d’analyse de données unifiée.

Vous pouvez à la fois stocker et préparer des données brutes sur la plateforme ce qui offre une flexibilité et évolutivité élevées. Par ailleurs, elle permet aux utilisateurs d’accéder à toutes leurs données sur la même plateforme.

Dans le cas de L’Oréal, la plateforme Lakehouse rassemblera toutes les données des plateformes cloud de la marque. Ce qui permettra d’avoir une visibilité totale du parcours client de la demande d’achat, de l’expédition aux soins et de l’expérience en ligne et hors ligne. De cette manière, la marque peut améliorer l’expérience client tant lors de la découverte, de l’essai et de la réception des produits en ligne et en magasin.

Il semblerait que la beauty tech soit la formule magique de L’Oréal au regard des bénéfices que l’entreprise en a tirés depuis le début de cette transformation en 2019. Nous notons entre autres : une amélioration de 20% de sa productivité grâce à une réduction des efforts de maintenance, une amélioration de l’exécution et une consommation cloud accrue. Il nous tarde de voir l’évolution de cette collaboration entre Databricks et L’Oréal dans les années à venir, et surtout l’impact pour le géant de la cosmétique.